Google IO.Lens整合即時翻譯功能 Search文字外更可呈現AR物件

Google I/O 2019開發者大會上,官方發表強大的AR(Augmented Reality 增強實境)新功能,力求即時、互動的嶄新畫面表達形式。簡單而言,AR系統將配合手機鏡頭,於空間中以3D立體AR物件展示Google Search的搜索結果。Google Lens將整合Translate,用家以手機鏡頭掃瞄外文,可即時以AR覆蓋層方式逐字翻譯內容。

Google I/O 2019正式發表AR增強實境功能加持之Google Search及Translate!Google行政總裁Sundar Pichai在I/O 2019大會台上表示,新功能背後概念是讓用家使用智能手機的相機鏡頭,將搜索結果以視覺資訊的形式表現出來。AR版Search將結合使用電腦視覺和AR增強實境技術,將手機變成強大的搜尋工具,加強即時互動和多媒體呈現效果。

不妨睇睇下面可見Google官方短片示範。於Google Search搜尋大白鯊相關資料,當中有3D CG立體鯊魚可動模型。在AR功能配合智能電話相機鏡頭支援底下,該可動模型更可變成AR物件,在家居草地上「浮現」:

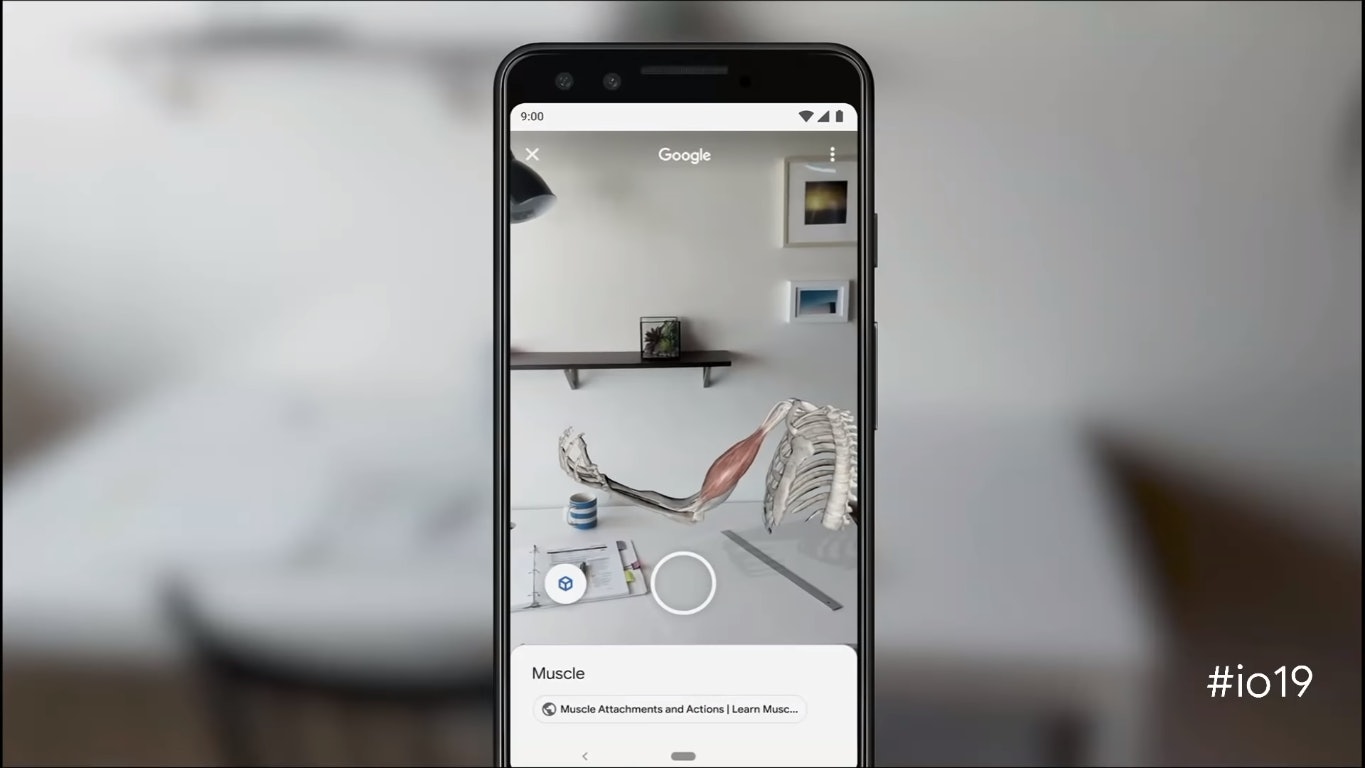

AR做到的事情很多,特別是以虛擬3D立體模型呈現搜尋結果,讓用家以另一方式來學習知識。例如有人於Google搜索「肌肉屈曲」相關內容,不久的將來便可以在搜索結果中查看3D肌肉模型,了解其運作機制;更可以手指滑動屏幕來移動模型、將之帶入現實的物理環境(如書枱)。如此操作全拜AR技術所賜。

Google I/O 2019展示另一個跟購物有關的AR應用例子。如果尋找New Balance波鞋,買家可以在手機上參看個別鞋款的3D立體模型,將之旋轉不同角度觀察。甚至可以把模型以AR物件形式放在你的現實衣物旁作配搭。第三方開發商可為其Google搜尋結果建立AR購物體驗。最先使用此3D AR物件功能的商家除New Balance外,更有美國太空總署NASA、Target、Samsung、Visible Body、Volvo和Wayfair。

配備機器學習(Machine Learning)和AI人工智能的Google Lens,也整合了Google Translate功能,變得更強大。Google Lens本可讓用家以手機鏡頭掃瞄物件,再即時於Google搜尋出有關該物件的資料。現將加入以AR覆蓋層方式即時翻譯外語的功能。翻譯形式有文本筆譯,在螢幕上以AR層膜蓋去原文;亦有語音口譯,將翻譯內容逐字讀出,每讀一字會將之Highlight顯示。用家亦可逐字點擊作Google Search搜尋,比對翻譯字義和原文字義,似乎對學習外語有一定幫助。

點擊放大圖片:

Google Lens也能協助揀選菜色。用家只需以Google Lens拍攝餐廳餐牌,系統便會自動標示出該食肆的熱門菜色,還輔以菜色照片和曾到訪的食客所撰食評,看看是否真的受歡迎。此功能讓用家外遊叫餸時有更多參考資料,減低「中伏」機會。再者,跟朋友出外食飯要夾錢,也可用Google Lens掃瞄單據,系統會自動顯示分帳計數機,點算貼士和除開條數,方便用家計算每人需付金額。

點擊放大圖片:

上述新功能,計劃在本月月底陸續推出。最後,不妨看看新版Google Lens即時AR翻譯功能的記者試用實測短片。

即睇Google I/O 2019 新版Google Lens即時AR翻譯功能 記者試用實測短片: